Kafka架构入门:以一个解耦SpringBoot和Python的需求为例。

Intro

Kafka简介

由 LinkedIn 开发的 Kafka 是一个开源的分布式事件流平台(Distributed Event Streaming Platform),旨在解决大规模数据传输中的低延迟与高吞吐难题,后贡献给 Apache 基金会。

在现代微服务架构与大数据体系中,Kafka 早已超越了传统消息队列(Message Queue)的范畴,成为处理流式数据、实现系统解耦以及构建实时数据管道的核心基础设施。

从计算机科学的角度定义,Kafka 是一个基于日志结构(Log-structured)的分布式发布-订阅消息系统。

其核心设计哲学源于预写日志(Write-Ahead Log, WAL)。在数据库设计中,WAL 用于保证事务的原子性和持久性;Kafka 将这一概念泛化,将数据流抽象为一个不可变的、有序的、仅支持追加写入的日志序列。

预写日志

预写日志(Write-Ahead Log,简称 WAL )是数据库和分布式系统中保证数据可靠性(Durability)和一致性(Consistency)的核心技术。它的核心逻辑是,在修改真正的数据库文件(数据页)之前,必须先将这次修改的行为记录在日志文件中,并持久化到磁盘上。

这种基于预写日志的设计带来了两个本质优势:

-

持久化(Durability):消息被直接写入磁盘,而非仅驻留在内存,确保数据不丢失。

-

顺序 I/O(Sequential I/O):利用磁盘的顺序读写特性,在机械硬盘(HDD)上也能实现接近内存的随机读写性能。

核心架构组件

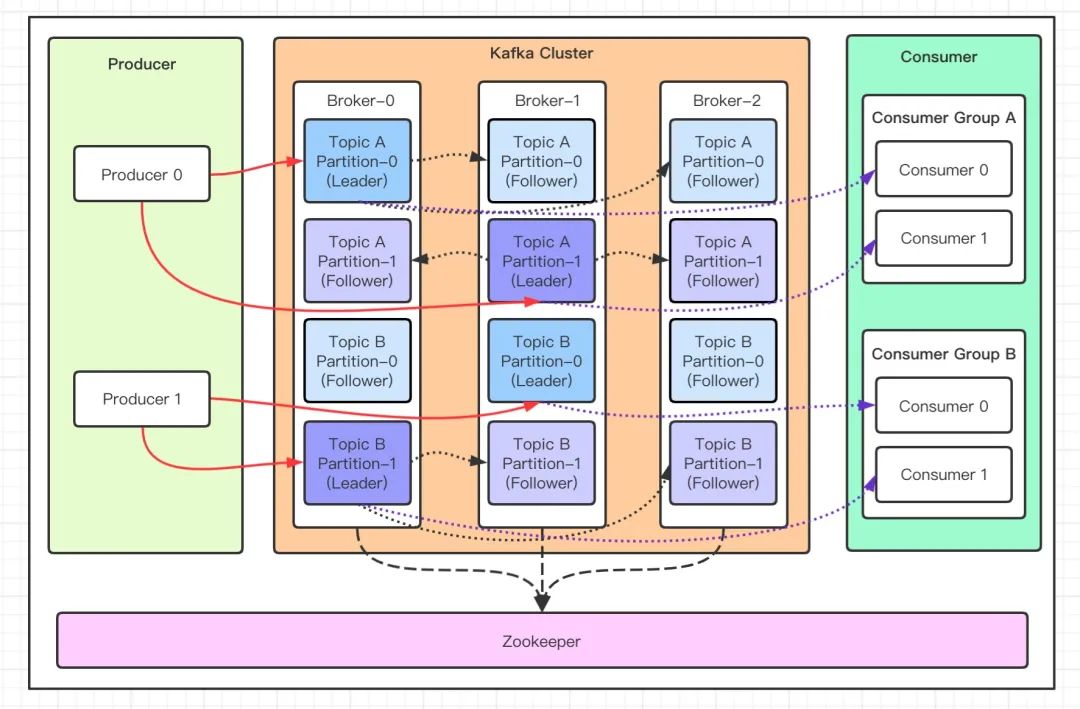

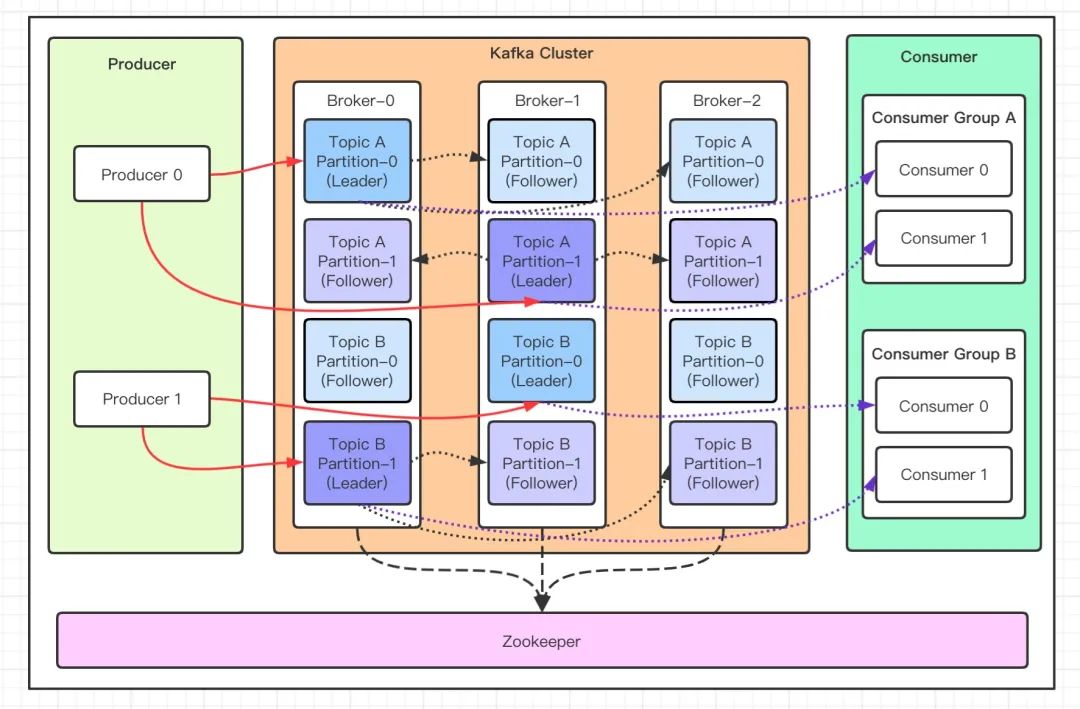

Kafka 的运行时架构由以下逻辑实体与物理节点构成:

Broker(代理节点)

Kafka 集群中的物理服务器节点。一个 Kafka 集群由多个 Broker 组成。Broker 负责接收生产者的消息、持久化存储数据至磁盘,并响应消费者的拉取请求。

Topic(主题)与 Partition(分区)

Producer(生产者)

Producer负责向 Topic 发送消息的客户端应用。

- 路由策略:生产者决定将消息发送到 Topic 的哪个 Partition。默认采用轮询(Round-robin)策略以实现负载均衡;若消息指定了 Key,则通过哈希算法(

Hash(Key) % PartitionCount)确保相同 Key 的消息始终写入同一 Partition,从而保证局部有序性。

Consumer(消费者)与 Consumer Group(消费者组)

这是 Kafka 区别于传统 MQ 最重要的设计模式。

- Consumer Group:一个逻辑上的订阅者集合。组内的每个消费者负责消费 Topic 中不同 Partition 的数据。

- 并行消费机制:一个 Partition 在同一时刻只能被同一个 Consumer Group 内的一个 Consumer 消费。这保证了消息处理的互斥性与顺序性。

- 发布/订阅模式:不同 Consumer Group 之间相互隔离,可以独立消费同一份数据(即广播模式)。

Replication(副本机制)与 ISR

为了保障高可用性(High Availability),每个 Partition 都有多个副本。

- Leader Replica:负责处理所有的读写请求。

- Follower Replica:被动地从 Leader 同步数据,仅用于故障转移(Failover)。

- ISR (In-Sync Replicas):处于同步状态的副本集合。只有 ISR 中的节点才有资格被选举为新的 Leader。

关键技术特性

Kafka 之所以能达到每秒百万级的吞吐量,主要依赖于以下底层机制:

- 零拷贝(Zero Copy)技术 :在传统的网络传输中,数据需经由“磁盘 -> 内核缓冲区 -> 用户缓冲区 -> Socket 缓冲区 -> 网卡”的多次拷贝。Kafka 利用操作系统的

sendfile 系统调用,直接将数据从 Page Cache 传输到 NIC(网卡)缓冲区,避免了上下文切换与多余的内存拷贝。

- 页缓存(Page Cache)利用 :Kafka 并不显式管理内存缓存,而是极度依赖操作系统的 Page Cache。这意味着即使 Java 进程重启,只要操作系统未崩溃,热点数据依然驻留在内存中,极大提升了读取性能。

- 批处理(Batching) :生产者并非逐条发送消息,而是将多条消息打包成 Batch 进行网络传输;服务端同样以 Batch 为单位进行磁盘写入。这有效减少了网络 RTT(往返时延)和磁盘 IOPS。

适用场景

基于上述架构,我们列举四个 Kafka 的常用场景:

1. 异步通信与解耦 (Asynchronous Decoupling)

在微服务架构中,缓解上游服务的压力,平滑突发流量(削峰填谷)。

用户上传了一个 500MB 的 PDF 文档给 Java 后端,Java 不需要死等解析进程解析完,而是直接把任务扔进 Kafka 并立刻告诉用户上传成功。后端的解析进程可以在后台从 Kafka 领取任务解析,互不干扰。

2. 日志聚合 (Log Aggregation)

作为 ELK (Elasticsearch, Logstash, Kibana) 技术栈的核心缓冲层,收集分布在数千台服务器上的业务日志

你有 100 台微服务节点,某个订单报错了。如果没有 Kafka,你需要登录 100 台机器去 grep 日志。有了 Kafka后,可以通过Elasticsearch集中管理。

3. 流式处理 (Stream Processing)

结合 Kafka Streams 或 Apache Flink,对实时数据流进行窗口计算、聚合与变换。

用户在短视频APP里每划过一个视频,这个行为就是一个事件流。可以通过 Kafka 实时捕获这些点击,使用流计算引擎立算用户的兴趣点,调整他的推荐算法。

4. 事件源 (Event Sourcing)

利用 Kafka 的持久化与有序性,将状态的变化记录为一系列事件序列,用于系统状态的重建与审计

在金融级应用中,仅维护当前的账户余额并不足以满足合规与溯源需求。通过 Kafka 持久化存储存款、消费、转账等一系列事务指令,当发生系统宕机或数据损毁时,系统能够通过顺序重放(Replay)事件序列,在内存中精确重建特定时刻的账户状态。

基础语法与 CLI 操作规范

创建主题 (Create Topic)

创建一个名为 tasks 的主题,包含 3 个分区与 1 个副本:

1

2

3

4

5

| bin/kafka-topics.sh --create \

--topic geo-tasks \

--bootstrap-server localhost:9092 \

--partitions 3 \

--replication-factor 1

|

查看主题详情 (Describe Topic)

用于确认分区分布与 Leader 节点位置。

1

2

3

| bin/kafka-topics.sh --describe \

--topic geo-tasks \

--bootstrap-server localhost:9092

|

生产消息 (Console Producer)

启动控制台生产者,向主题发送消息。

1

2

3

4

5

| bin/kafka-console-producer.sh \

--topic geo-tasks \

--bootstrap-server localhost:9092

> {"id": 1, "action": "ingest", "file": "map.shp"}

|

消费消息 (Console Consumer)

启动控制台消费者。注意:在生产环境中,必须指定 group.id 以便管理消费进度。

1

2

3

4

5

| bin/kafka-console-consumer.sh \

--topic geo-tasks \

--bootstrap-server localhost:9092 \

--group georag-backend-group \

--from-beginning

|

--from-beginning:表示从 Topic 的起始位置开始消费,而非仅消费启动后新到达的消息。--group:指定消费者组 ID。Kafka 会自动记录该组消费到的 Offset。

项目简介

由于本次项目的需求,仅介绍 Kafka 作为 MQ 是的应用方法。

在本项目中,Spring Boot持有与前端用户的 WebSocket 连接、HTTP 会话(Session)以及业务数据库的读写权限。而Python是后台计算引擎,负责 CPU/GPU 密集型的 AI 运算,但不直接与用户浏览器通信。

在任务下发流程中,Spring Boot接受到用户发起的请求后,会做以下工作:

- 生成一个唯一的 Task ID

- 将任务载荷(例如

{ "taskId": "1001", "fileUrl": "/data/a.shp" })封装成 JSON。

- 将消息写入 Kafka 的 请求主题(例如

topic-task-request)。

- 写入 Kafka 后,立即向前端返回 HTTP 200 “Task Received”,释放 Web 线程。

- Python 监听

topic-task-request,当轮到该消息时,Python 拉取数据,开始执行运算。

在结果回传流程中,Python 运算结束,生成结果数据后,会做以下工作:

- 将结果封装成 JSON,带上之前的 Task ID(例如

{ "taskId": "1001", "status": "DONE", "vector": [...] })。

- 将消息写入 Kafka 的 结果主题(例如

topic-task-result)。这里是写入另一个不同的 Topic,实现了读写分离。

- Java(配置了

@KafkaListener)实时监听 topic-task-result。

- 一旦收到消息,Java 解析 JSON,提取

taskId。

- Java 根据

taskId 找到对应的业务记录,找到对应的用户连接,将最终结果实时推送给前端展示。

该流程就是一次全双工通信。

全双工通信

全双工通信(Full-Duplex Communication)是数据通信的一种方式,指数据可以同时在两个方向上传输。其要求通信时在通信链路上拥有独立的两条路径,一条用于发送(TX),一条用于接收(RX),并在同一条物理路径上,通过不同的频率(FDD)或极短的时间切片(TDD)来区分发送和接收信号。

Spring Boot 集成 Kafka

基础配置

在微服务架构中,Spring Boot 通过 spring-kafka 项目提供了对 Kafka 客户端的高级抽象。它封装了底层的 KafkaProducer 和 KafkaConsumer API,通过自动配置与模板模式,极大降低了通过 Java 进行流式交互的复杂度。

首先,需要在构建工具中引入 Spring Kafka 的官方 Starter 依赖,如:

1

2

3

4

5

6

7

8

| <dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

</dependency>

<dependency>

<groupId>com.fasterxml.jackson.core</groupId>

<artifactId>jackson-databind</artifactId>

</dependency>

|

Kafka 是基于字节流传输的,因此必须明确定义键(Key)与值(Value)的序列化与反序列化策略(SerDes)。考虑到系统后续需与 Python 服务进行交互,采用 JSON 作为 Payload 标准是最好的。

配置文件application.yml如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

| spring:

kafka:

bootstrap-servers: localhost:9092 # 集群接入点地址

# 生产者配置

producer:

# 重试次数,增强网络抖动下的容错性

retries: 3

# 确认机制:all 代表 Leader 和 ISR 队列所有副本都确认写入才视为成功,保障数据强一致性

acks: all

# 批处理大小(字节),提升网络吞吐

batch-size: 16384

# 序列化器:Key 使用字符串,Value 使用 JSON

key-serializer: org.apache.kafka.common.serialization.StringSerializer

value-serializer: org.springframework.kafka.support.serializer.JsonSerializer

properties:

# 自定义 JSON 类型映射,防止反序列化时的安全限制

spring.json.trusted.packages: "*"

# 消费者配置

consumer:

# 默认消费者组 ID,用于标识逻辑订阅者集合

group-id: georag-backend-group

# 当 Offset 丢失时的策略:earliest (从头消费), latest (只消费新消息)

auto-offset-reset: earliest

# 反序列化器:需与生产者对应

key-deserializer: org.apache.kafka.common.serialization.StringDeserializer

value-deserializer: org.springframework.kafka.support.serializer.JsonDeserializer

properties:

spring.json.trusted.packages: "*"

|

生产者

Spring Boot 提供的 KafkaTemplate 是线程安全的,支持并发发送。在生产环境中,必须采用异步回调来处理发送结果,避免主线程阻塞。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

| import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.kafka.support.SendResult;

import org.springframework.stereotype.Service;

import java.util.concurrent.CompletableFuture;

@Service

public class EventProducer {

private final KafkaTemplate<String, Object> kafkaTemplate;

public EventProducer(KafkaTemplate<String, Object> kafkaTemplate) {

this.kafkaTemplate = kafkaTemplate;

}

public void sendGeoTask(String topic, String key, Object payload) {

CompletableFuture<SendResult<String, Object>> future = kafkaTemplate.send(topic, key, payload);

future.whenComplete((result, ex) -> {

if (ex == null) {

System.out.printf("Sent message to topic: %s, partition: %d, offset: %d%n",

topic,

result.getRecordMetadata().partition(),

result.getRecordMetadata().offset());

} else {

System.err.println("Unable to send message due to: " + ex.getMessage());

}

});

}

}

|

消费者

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

| import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.kafka.support.Acknowledgment;

import org.springframework.stereotype.Component;

@Component

public class EventConsumer {

@KafkaListener(topics = "topic-knowledge-result", groupId = "georag-backend-group")

public void handleGeoResult(ConsumerRecord<String, String> record, Acknowledgment ack) {

try {

String fileId = record.key();

String resultJson = record.value();

System.out.printf("Received result for file %s from partition %d%n", fileId, record.partition());

processResult(fileId, resultJson);

ack.acknowledge();

} catch (Exception e) {

System.err.println("Error consuming message: " + e.getMessage());

}

}

private void processResult(String fileId, String data) {

}

}

|

Python 集成 Kafka

在 Python 生态中,主流的 Kafka 客户端库有两个:

kafka-python:纯 Python 实现,安装简便,社区活跃,适合大多数中等吞吐场景confluent-kafka:基于 C 语言 librdkafka 的封装,性能极高,适合超高吞吐场景。

考虑到个人的项目属于计算密集型而非 I/O 密集型(瓶颈在于 GPU 推理而非网络吞吐),采用代码可读性更强的 kafka-python 是合理的工程选择。

安装依赖:

1

| pip install kafka-python

|

消费者

为了接收 Java 端 JsonSerializer 发送的消息,Python 端必须严格遵循对应的反序列化协议。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

| import json

import logging

import time

import signal

import sys

from kafka import KafkaConsumer, KafkaProducer

from kafka.errors import KafkaError

KAFKA_BOOTSTRAP_SERVERS = ['localhost:9092']

TOPIC_INPUT = 'topic-knowledge-ingest'

TOPIC_OUTPUT = 'topic-knowledge-result'

GROUP_ID = 'georag-python-worker-group'

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

logger = logging.getLogger(__name__)

class GeoRAGWorker:

def __init__(self):

self.running = True

self.consumer = KafkaConsumer(

TOPIC_INPUT,

bootstrap_servers=KAFKA_BOOTSTRAP_SERVERS,

group_id=GROUP_ID,

auto_offset_reset='earliest',

enable_auto_commit=False,

value_deserializer=lambda m: json.loads(m.decode('utf-8')),

max_poll_interval_ms=600000

)

self.producer = KafkaProducer(

bootstrap_servers=KAFKA_BOOTSTRAP_SERVERS,

value_serializer=lambda v: json.dumps(v).encode('utf-8')

)

signal.signal(signal.SIGINT, self.shutdown)

signal.signal(signal.SIGTERM, self.shutdown)

def shutdown(self, signum, frame):

logger.info("Received shutdown signal. Stopping worker...")

self.running = False

def start(self):

logger.info(f"Worker started. Listening on {TOPIC_INPUT}...")

try:

while self.running:

msg_pack = self.consumer.poll(timeout_ms=1000)

for partition, messages in msg_pack.items():

for message in messages:

if not self.running: break

self._handle_single_message(message)

except Exception as e:

logger.error(f"Critical worker error: {e}", exc_info=True)

finally:

self.consumer.close()

self.producer.close()

logger.info("Kafka connections closed. Bye.")

def _handle_single_message(self, message):

"""

处理单条消息的生命周期:解析 -> 执行 -> 回传 -> 提交

"""

try:

payload = message.value

task_id = payload.get('fileId') or payload.get('taskId')

logger.info(f"Received Task [{task_id}] from partition {message.partition}")

result_data = self.process_business_logic(payload)

self._send_result(task_id, result_data)

self.consumer.commit()

except Exception as e:

logger.error(f"Error processing message: {e}")

def process_business_logic(self, payload):

"""

[占位函数] 在此处填入你的 GeoRAG / 深度学习推理逻辑

"""

return {

"status": "SUCCESS",

"message": "Vectorization complete",

"vector_ids": [101, 102, 103]

}

def _send_result(self, task_id, data):

"""

发送处理结果到输出 Topic

"""

response = {

"taskId": task_id,

"timestamp": time.time(),

"payload": data

}

future = self.producer.send(TOPIC_OUTPUT, value=response)

future.get(timeout=10)

if __name__ == '__main__':

GeoRAGWorker().start()

|

死信队列

若缺乏隔离机制,一条无法被正常处理的消息(即“毒丸消息”,Poison Pill)会导致消费者陷入 “读取 -> 崩溃 -> 重启 -> 再读取” 的死循环,进而阻塞分区内后续所有正常消息的处理。死信队列(Dead Letter Queue, DLQ) 正是解决这一问题的标准架构模式。

在没有 DLQ 的架构中,消费者的默认行为通常是“失败重试”。然而,对于确定性错误(如数据格式损坏、业务逻辑冲突),无限重试毫无意义,只会导致消费滞后迅速累积,最终拖垮整个处理链路。

引入 DLQ 后,系统的容错逻辑变更为:

- 重试(Retry):在遇到瞬态错误(如网络抖动)时,进行有限次数的重试。

- 隔离(Isolate):当重试耗尽或遇到非恢复性错误时,将该消息转移至 DLQ 主题。

- 提交(Commit):向 Kafka 提交原消息的 Offset,欺骗 Broker 认为该消息已被消费,从而让消费者指针向前移动,继续处理后续的正常数据。

以下是死信生产的标准时序流程:

- 消息拉取 (Fetch):消费者从

topic-knowledge-ingest 获取 Offset 为 N 的消息。

- 业务试错 (Try):将 Payload 传入核心业务逻辑。

- 异常抛出 (Throw):业务逻辑因数据格式错误抛出

ValueError 或 JSONDecodeError。

- 异常捕获 (Catch):在最外层拦截该异常,阻止 Worker 崩溃。

- 死信封装 (Wrap):将原始消息 + 错误堆栈打包成新的 JSON 对象。

- 死信投递 (Produce):将封装包发送至

topic-knowledge-ingest-dlq。

- 伪装成功 (Commit):向 Kafka 提交 Offset

N,欺骗 Broker 认为该消息已被“成功消费”。从而让消费者指针移动到 N+1,继续处理后续正常任务。